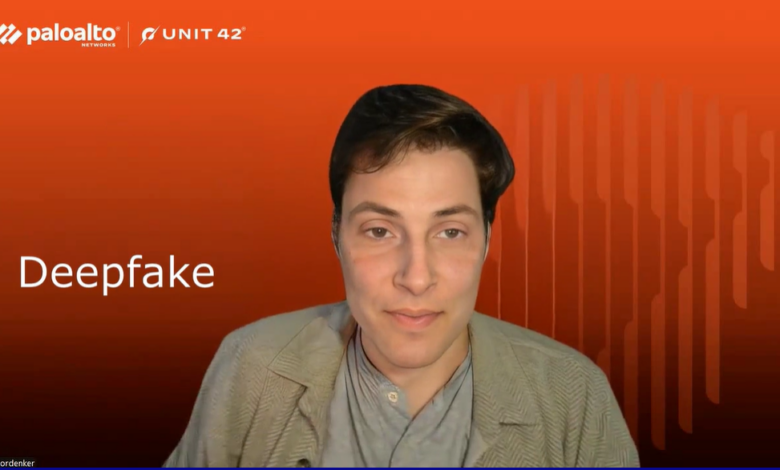

Deepfakes en entrevistas de trabajo: así se infiltran falsos candidatos.

Unit 42 demuestra lo alarmantemente fácil que es crear identidades sintéticas en tiempo

real y alerta del uso creciente de esta técnica, especialmente empleada por parte de

trabajadores TI norcoreanos para infiltrarse en empresas internacionales creados con IA en empresas.

Madrid, 25 de abril de 2025 –El uso de identidades falsas mediante deepfakes en tiempo real durante entrevistas laborales es ya una realidad en aumento. Así lo alerta una nueva investigación de Unit 42, la unidad de ciberinteligencia de Palo Alto Networks, el líder global en ciberseguridad, que demuestra lo fácil que resulta hoy crear una identidad falsa y convincente con inteligencia artificial. Una técnica que, además, está siendo utilizada por trabajadores TI vinculados al régimen de Corea del Norte en campañas de infiltración remota en empresas internacionales.

En su experimento, un analista de Unit 42 sin experiencia en manipulación de imágenes y con conocimientos limitados sobre tecnología deepfake generó una identidad sintética funcional en apenas 70 minutos, utilizando imágenes generadas por IA a través de plataformas como thispersondoesnotexist.org , un software gratuito y un ordenador doméstico. El informe demuestra que el mayor reto no fue la creación del rostro, sino configurar una cámara virtual para simular una videollamada en tiempo real.

En la misma investigación, los expertos de Unit 42 replicaron el proceso utilizando un equipo más potente y técnicas más avanzadas, lo que permitió generar un deepfake de mayor calidad y realismo.

No obstante, la amenaza no se limita al laboratorio. El informe recoge casos reales, como el de una empresa tecnológica en Polonia que detectó similitudes entre dos candidatos distintos y sospechó que se trataba de la misma persona operando con identidades separadas, o entrevistas en las que los candidatos mostraban vídeos sintéticos, utilizando fondos virtuales idénticos entre distintos perfiles.

A lo largo del informe, Unit 42 conecta estos hallazgos con las tácticas, técnicas y procedimientos (TTPs) previamente atribuidos a los trabajadores TI de Corea del Norte. Ya en 2023, el equipo documentó cómo estos operativos creaban perfiles sintéticos respaldados por datos personales robados, lo que dificultaba su detección en procesos de verificación tradicionales.

Cómo detectar una identidad sintética

A pesar de su creciente sofisticación, las técnicas de deepfake en tiempo real aún presentan limitaciones que pueden servir como señales de alerta. La investigación de Unit 42 identifica varios recursos útiles durante una entrevista en vídeo: pedir al candidato que mueva la cabeza bruscamente, pase la mano por delante del rostro o realice expresiones faciales marcadas puede generar errores visuales detectables.

También se han observado desajustes más sutiles, como desfases entre el audio y el movimiento de los labios, problemas de iluminación en los bordes del rostro o fallos al superponer elementos como gafas o manos.

El informe propone una respuesta coordinada entre los departamentos de Recursos Humanos y Ciberseguridad para reducir los riesgos asociados a estas suplantaciones:

- Solicitar la activación de cámara en todas las entrevistas (con consentimiento para grabar).

- Verificar documentos con herramientas de verificación y exigir pruebas de vida en tiempo real (como mostrar un documento y realizar gestos específicos).

- Analizar la procedencia de las IPs y detectar el uso de VPNs o cámaras virtuales.

- Establecer verificaciones adicionales antes de conceder accesos sensibles.

- Formar a los equipos de selección para identificar signos de manipulación facial o comportamientos sospechosos.

El informe completo está disponible en el blog de Unit 42 de Palo Alto Networks, donde se incluyen vídeos demostrativos del proceso de creación de deepfakes, así como ejemplos visuales de identidades sintéticas y manipulaciones faciales.

I completely agree with your points. Well said!

I love how you addressed this issue. Very insightful!

This is a great resource. Thanks for putting it together!